Стан пошукової оптимізації у 2025 році характеризується безпрецедентним протистоянням між алгоритмами глибокого навчання Google та складними методами маніпуляції, що базуються на великих мовних моделях. Екосистема Black Hat SEO трансформувалася з примітивного спаму в інтелектуальну симуляцію авторитетності та користувацької задоволеності. Те, що раніше давало 12 місяців стабільного ранжування, тепер працює максимум 2-8 місяців до виявлення та санкцій.

Протягом 2025 року Google випустив три основні Core Updates (March, June, December) та спеціалізований August Spam Update, які радикально змінили ландшафт тіньового просування. Основний фокус пошукової системи змістився з аналізу окремих сторінок на оцінку цілісних сигналів сайту через модуль QualityCopiaFireflySiteSignal, що дозволяє ідентифікувати масштабовані зловживання контентом на рівні архітектури ресурсу.

Денні Салліван, Google Search Liaison, чітко окреслив позицію системи: “Контент, створений насамперед для ранжування в пошукових системах, а не для допомоги людям, може мати погані результати незалежно від того, чи створив його штучний інтелект, чи людина.”

Ключова трансформація полягає в тому, що масштабованість більше не є стратегією. Той, хто копіює 100 тисяч дорвеїв з однією змінною, отримує алгоритмічну смерть за лічені дні. Натомість найефективніші чорні оптимізатори у 2025 році зосереджуються на якості імітації та мікро-масштабуванні від 10 до 50 унікальних активів замість тисяч.

Еволюція дорвеїв та масова генерація сторінок

Традиційне розуміння дорвеїв як статичних сторінок, перенасичених ключовими словами, остаточно втратило актуальність. У 2025 році чорні оптимізатори перейшли до створення динамічних вузлів контенту, які використовують LLM для генерації текстів, що на перший погляд не відрізняються від експертних матеріалів.

LLM-генеровані дорвеї: практично мертві

Після запуску August 2025 Spam Update Google систематично деіндексовував сайти, побудовані на принципі масової генерації контенту. Типовий сценарій виглядав так: клієнт запускав 50 тисяч варіацій сторінки "Найкраща SEO-послуга в [Місто]", кожна з 90% дублювання контенту. Результат - фактична деіндексація всього домену.

Технічна причина полягає в тому, що Google використовує NLP (Natural Language Processing) для виявлення повторюваних лінгвістичних патернів у AI-контенті. Система розпізнає однакову структуру речень, передбачуваний розподіл слів та нестачу оригінальної глибини думки.

Реальний приклад: один клієнт мав вісім мільйонів сторінок на диску, але Google заіндексував лише 650 тисяч із них. Після штрафу навіть нові якісні статті перестали ранжуватися, оскільки домен був позначений системою SpamBrain.

Programmatic SEO як маскування спаму

Межа між легітимним програмним SEO та спамом у 2025 році визначається поняттям "доданої вартості". Google почав масово деіндексувати проекти, де автоматизація використовувалася для клонування контенту з мінімальними змінами.

Основний критерій бану - відсутність унікальних даних або функціоналу (калькулятори, реальні відгуки, власні бази даних), які б виправдовували існування тисяч сторінок. Компанії, що намагалися прикрити спам технологією Programmatic SEO, зіткнулися з Manual Actions після березневого та червневого оновлень.

Типовий сценарій штрафу: 200 сторінок "Найкращий сантехнік у [Місто]" з однаковим контентом призводили до алгоритмічного покарання та відмови Google від індексації нового контенту.

На межі легальності знаходиться "білий програмний SEO", де кожна сторінка має справжні дані з місцевих джерел, унікальні відгуки реальних клієнтів та різні архітектури контенту. Такий підхід все ще працює, але під посиленим наглядом.

Схема "Пироги" в арбітражі трафіку

У контексті арбітражу трафіку термін "Пироги" описує багатошарові структури переспрямування користувачів. Ця схема передбачає створення "сендвіча" з доменів:

Верхній шар (Tier 1) складається з білих, трастових сайтів або Parasite SEO сторінок на великих платформах, які збирають органічний трафік. Ці ресурси виглядають легітимно для пошукових систем.

Середній шар виконує роль фільтра (клоакінгу), що відсікає ботів Google через JavaScript fingerprinting та аналіз понад 900 параметрів браузера. Система визначає, чи є відвідувач реальною людиною або пошуковим роботом.

Нижній шар - це цільова сторінка з офером, яка містить комерційний контент або порушує політики Google.

"Склеювання" трафіку відбувається через складні ланцюжки 301-редиректів та маніпуляції з атрибутом Canonical, що дозволяє передавати посилальну вагу від чорних дорвеїв до основного проекту, мінімізуючи ризик прямої санкції. Ефективність така в арбітражі висока, але ризик деіндексації оцінюється як середній.

Маніпуляція посиланнями: PBN, дропи та ін’єкції

Посилання залишаються валютою пошукового просування, проте у 2025 році Google остаточно перейшов до оцінки контекстуальної ваги посилання, а не лише авторитетності домену. Це змусило власників Private Blog Networks кардинально змінити підхід до приховування мереж.

Приховування слідів у мережах PBN

У 2025 році стандартні методи приховування PBN, такі як різні IP-адреси та DNS, стали недостатніми. Google використовує просунутий аналіз графа посилань для виявлення закритих сіток через систему, що враховує shared infrastructure (DNS records, IP ranges, hosting provider patterns), AI-text patterns через глибокий NLP-аналіз для виявлення однорідних авторств, link velocity (якщо 20 маловідомих сайтів раптом дають посилання одному домену за три дні) та anchor text distribution.

Чорні оптимізатори відповіли стратегією “розмивання відбитків”. Замість одноманітних WordPress-сайтів вони почали використовувати різні CMS (Ghost, Hugo, статичні сайти на S3). Посилальні профілі змішуються: сайти посилаються не лише на маніпулятивні акцептори, а й на великі медіа, Вікіпедію та державні ресурси для симуляції природності.

Генеруються фальшиві профілі авторів із підтвердженими соціальними сигналами (LinkedIn, X) для проходження перевірок на E-E-A-T. Google навчився деіндексувати такі мережі автоматично, якщо система виявляє ідентичну динаміку публікацій та одночасну появу посилань на групу непов’язаних сайтів.

Реальна тактика успішного PBN у 2025 році: 10-15 дропів із різних хостинг-провайдерів (не бюджетних), кожен сайт має справжнього автора з різними email та IP, посилання даються не більше 2-3 на місяць (низька швидкість), 40% постів посилаються на авторитетні сайти для вигляду природності. Результат: часто діють 3-6 місяців перед м’яким штрафом.

Класичні PBN у стилі 2014-2020 років деіндексуються за 30-90 днів, оскільки Google має логову базу відомих спам-мереж і порівнює нові домени. Навіть “невидимі” PBN із максимальним маскуванням працюють 2-8 місяців, після чого мета-аналіз Google виявляє мережу.

Ефективність Expired Domains та 301-редиректів

Стратегія простої “підклейки” авторитету через 301-редирект із дроп-домену у 2025 році практично перестала працювати при зміні тематики. Google впровадив механізм обнулення ваги посилань (“Reset History”), якщо новий вміст сайту не відповідає його історичному профілю. Це було офіційно закріплено в політиці “Expired Domain Abuse” у березні 2024 року та посилено протягом 2025 року.

301-редирект все ще передає вагу, але умовно. Якщо дроп релевантний новому домену, передача становить 70-90% старої ваги. Якщо дроп мав спам-історію, Google обнуляє вагу при виявленні тематичної зміни. Якщо використовується для арбітражу, перенаправлення трафіку призводить до штрафу.

Найбільш ефективним методом залишається “Strategic Merger” (стратегічне злиття), де створюється сторінка-наступник на новому домені, що повністю відповідає інтенту старої популярної сторінки дропа. У такому разі Google може зберегти до 90% посилальної ваги. Time to Live таких стратегій: 6-18 місяців з помірним ризиком при дотриманні релевантності та відсутності спам-історії.

Проблема “підклеювання авторитету”: старі домени з 500+ посиланнями часто були покарані за попередній спам, Google нараховує меншу вагу, якщо регіон або мова змінилася, рідкісні дропи підлягають деіндексації швидше, ніж раніше.

Актуальність посилань із зламаних сайтів

Використання XSS-ін’єкцій та розміщення прихованих посилань на зламаних .edu та .gov сайтах у 2025 році перейшло у категорію надвисокого ризику. Хоча такі посилання все ще дають потужний короткостроковий буст, тривалість їхнього життя скоротилася до 10-14 днів.

У 2025 році виявлено 135 тисяч скомпрометованих сайтів. Посилання з .edu/.gov доменів залишаються цінними, але виявляються протягом 24-48 годин. Time to Live таких посилань: 1-3 місяці перед очисткою.

Типовий приклад атаки: хакер компрометує WordPress-плагін, що використовується на 50 тисячах сайтів, впроваджує JavaScript для редиректу на казино, 10 тисяч WordPress-сайтів заражаються за 72 години. Google виявляє це, позначає як “malware” або “compromised”, посилання видаляються з індексу за тиждень.

Висновок експертів: Link injection як стратегія довгострокового ранжування неефективна у 2025 році. Максимум – одноразовий буст перед виявленням. Старі біржі посилань (типу “Сапа”) використовуються переважно для просування за низькочастотними запитами у геолокаціях із низькою конкуренцією, оскільки їхні патерни давно відомі антиспам-команді Google.

"Те, що контент третьої сторони може бути якісним, не скасовує факту зловживання репутацією основного сайту для отримання несправедливої переваги"

Денні Салліван

Parasite SEO та політика Site Reputation Abuse

Рік 2025 став переломним для методу Parasite SEO. Після оголошення політики Site Reputation Abuse у травні 2024 року Google почав активно застосовувати Manual Actions проти великих видавців, які дозволяли стороннім особам публікувати комерційний контент під виглядом редакційних матеріалів.

Визначення та реакція Google

Site Reputation Abuse означає публікацію матеріалів третіх сторін на довіреному домені для експлуатації його сигналів рейтингу. Наприклад, тисячі SEO-статей на Medium.com або партнерський контент на Forbes, що маскується під редакційні огляди.

Денні Салліван акцентує: "Те, що контент третьої сторони може бути якісним, не скасовує факту зловживання репутацією основного сайту для отримання несправедливої переваги."

Статус методу у 2025 році суперечливий. Очікувалося алгоритмічне виявлення без ручних санкцій, але реальність виявилася іншою: Google почав видавати manual actions після November 2024 update. Європейський Союз навіть відкрив розслідування проти Google на предмет несправедливого застосування цієї політики, стверджуючи, що легітимні видавці фінансуються через гостьовий контент.

Аналіз виживання платформ

Багато авторитетних доменів втратили позиції:

Outlook India та Forbes стали основними цілями першої хвилі санкцій. Розділи з партнерським контентом були масово деіндексовані, особливо матеріали на теми онлайн-казино та сумнівних послуг.

Medium ще працює, але ефективність впала на 50-60% порівняно з попередніми роками. Google знижує довіру до Medium як хосту спаму. Ризик помірний, оскільки платформа все ще має певну авторитетність.

Reddit працює добре, особливо нові subreddits. Ризик низький, оскільки це користувацький контент, який виглядає менш автоматизованим. У 2025 році ці платформи стали головними бенефіціарами оновлень, оскільки Google надає пріоритет форумам у видачі, вважаючи їх джерелом реального людського досвіду.

LinkedIn теоретично працює, але перебуває під жорстким контролем. Брендований контент виглядає менш спамоподібним, але LinkedIn часто видаляє спамові матеріали. Ризик помірний.

Quora фактично вже не працює через масові SEO-атаки попередніх років. Google зменшив вагу цієї платформи. Ризик високий.

Forbes Guest Posts все ще потужні, якщо справді опубліковані через редакційну перевірку. Справжня видавнича перевірка забезпечує більше довіри, ризик низький.

Реальна тактика Parasite SEO у 2025 році

Публікація на Reddit із цінним контентом (не спам, справжня цінність), посилання на власну сторінку з контекстом. Результат: трафік, посилання та соціальні сигнали. Time to Live: 3-12 місяців, поки не буде видалено модераторами.

Medium з утриманням посилань "натурально": 1-2 посилання в статті, не 10 на один домен. Результат: іноді дає ранги за 2-4 тижні. Ризик низький, якщо немає масової публікації.

LinkedIn Articles, опубліковані в компаніях: публікація статей від імені кількох профілів. Результат: ранги, але менша тривалість, ніж раніше. Ризик помірний.

Це спонукало чорних SEO-шників до масової накрутки акаунтів та створення фейкових гілок обговорень, щоб скористатися довірою Google до форумів.

Накрутка поведінкових факторів та CTR-маніпуляції

У 2025 році поведінкові фактори стали домінуючим сигналом для ранжування у конкурентних нішах. Оскільки Google все більше покладається на RankBrain та нові системи оцінки задоволеності, маніпуляція кліками та часом перебування на сайті стала обов’язковим елементом Black Hat стратегій.

Теорія проти реальності

Теоретично Google використовує CTR як сигнал якості контенту: якщо сторінка має вищий, ніж очікуваний, CTR, вона вважається релевантнішою. Однак Google офіційно заявив, що CTR – це занадто шумовий сигнал.

Внутрішні документи, що витекли у “Google Leak” 2024 року, показують іншу картину: link velocity є найсильнішим сигналом у SpamBrain, anchor text pattern – другим за впливом, а CTR – лише допоміжним фактором.

Лілі Рей, експерт із SEO, зазначає: “Контент, заснований на реальному досвіді, ймовірно, стане критично важливим для того, щоб виділитися серед маси матеріалів, згенерованих штучним інтелектом.”

Використання AI-агентів та ботнетів

Замість примітивних клік-ферм у 2025 році використовуються автономні AI-агенти. Ці боти не просто переходять за посиланням, а імітують складну поведінку:

Пошук за брендовим запитом для зміцнення авторитету сутності. Боти вводять назву компанії в пошук, щоб створити враження популярності бренду.

Вивчення сторінки: скролінг, виділення тексту, кліки по неактивних елементах. Це імітує природну поведінку користувача, який читає та взаємодіє з контентом.

“Пого-стікінг” на сайти конкурентів (швидке повернення до видачі) та тривале перебування на цільовому сайті (Dwell Time). Це створює враження, що конкуренти не задовольняють запит, а цільовий сайт – так.

Google розпізнає CTR-боти через аналіз географії кліків (чи всі вони з однієї країни), bounce rate (якщо відвідувачі одразу йдуть назад), time on page (якщо бот присутній 2 секунди).

Ефективність CTR-маніпуляцій у 2025 році

Різні методи мають різну ефективність:

Microtask Workers (Fiverr, Upwork): Time to Live 2-7 днів, зміна позиції на 2-3 місця, ризик високий через низьку якість імітації.

Click bots з IP rotation: TTL 3-14 днів, зміна на 1-5 позицій, середній ризик (виявляються патернами).

Headless Browser (Puppeteer, Selenium): TTL 1-30 днів, зміна на 1-3 позиції, середній ризик (поведінка недосконала).

Organic social sharing: TTL 1-3 місяці, зміна на 2-7 позицій, низький ризик (справжні люди).

Експеримент Ренда Фішкіна (2022-2024): організація фоловерів для пошуку та кліків дала результат у вигляді двох тижнів на топі, потім повернення до вихідної позиції. Висновок: тимчасовий буст без довгострокового ефекту.

CTR-маніпуляція у 2025 році дає короткий 2-7-денний буст, потім система повертає рангу на місце. Ефективна лише для Tier 2/3 проектів перед капітальною санкцією у форматі “Churn & Burn”.

"Контент, заснований на реальному досвіді, ймовірно, стане критично важливим для того, щоб виділитися серед маси матеріалів, згенерованих ШІ"

Лілі Рей

Технічні маніпуляції та клоакінг нового покоління

Сучасний клоакінг у 2025 році зосереджений на обході AI-детекторів та систем оцінки Helpful Content. Оптимізатори використовують технології підміни контенту на основі глибинного аналізу вхідного запиту.

AI-powered клоакінг

Старі методи (простий фільтр по User-Agent) померли. Нові сервіси cloaking-as-a-service використовують JavaScript Fingerprinting (понад 900 параметрів: браузер, шрифти, GPU, timezone), Machine Learning Detection (система порівнює користувача зі 100 тисячами відомих bot-подібних поведінок) та Dynamic content swapping (одна верстка для Google, інша для користувачів). Вартість базової версії становить близько $100 на місяць.

Semantic Cloaking

пошуковим роботам віддається текст, ідеально оптимізований під LSI та сутності (Entities), тоді як звичайні користувачі бачать агресивну рекламу або спрощений інтерфейс.

Interaction-based Content

сторінка завантажується порожньою для ботів (якщо вони не виконують JavaScript), а контент з'являється лише після реальної взаємодії користувача з браузером, що ускладнює роботу автоматичних антиспам-сканерів.

Ефективність для SEO: показ "гарних" сторінок Google та вмісту, що порушує політику, реальним користувачам працює 1-3 місяці. Google запустив runtime analysis для виявлення таких трюків. Ризик: Manual action за клоакінг або повна деіндексація.

Indexing API Abuse: закрито у вересні 2024

Що було раніше: нелегітимне використання Google Indexing API для масової індексації будь-яких сторінок, які входили в індекс за хвилини. Чорні оптимізатори могли заганяти в індекс мільйони сторінок через множинні сервісні акаунти Google Cloud Platform.

Що стало у вересні 2024 року: Google додав жорстку систему виявлення спаму для всіх API-запитів. API більше не підтримує будь-які типи контенту, тільки job postings та live streams. Порушення призводить до негайного відхилення та потенційної блокування API-доступу.

Google впровадив жорсткі квоти (зазвичай 200 URL на день для нових проектів) та почав вимагати підтвердження власності на рівні домену для кожного запиту. Результат: Churn & Burn схеми з Indexing API абсолютно неефективні у 2025 році.

"Контент отримує найнижчу оцінку (Lowest), коли текст, зображення або відео скопійовані, перефразовані, створені ШІ або просто перепубліковані з іншого джерела без доданої вартості"

Джон Мюллер

Класифікація методів за ефективністю та ризиками

Ще працює (висока ефективність при помірних витратах)

Semantic Parasite SEO (Reddit/Quora): публікація якісного контенту з природними посиланнями на авторитетних платформах. TTL 3-12 місяців, ROI середній (2-5X), ризик середній. Порада: якісний контент, мало посилань.

Strategic 301 Merger: злиття релевантного дроп-домену з новим проектом при збереженні тематичної відповідності. TTL 6-18 місяців, ROI середній (1-2X), ризик помірний. Порада: релевантність обов’язкова, без спам-історії.

Human-edited Programmatic SEO: автоматична генерація з унікальними даними, функціоналом та людським редагуванням. TTL 3-18 місяців, ROI середній, ризик низький-середній. Порада: справжня цінність, дотримання E-E-A-T.

Мініатюрні PBN (5-10 дропів): невеликі мережі з максимальним маскуванням слідів. TTL 2-8 місяців, ROI низький-середній, ризик середній-високий. Порада: максимальне маскування footprints.

Працює, але ризиковано (Churn & Burn)

AI-driven CTR Manipulation: використання ботів для короткострокового буста позицій. TTL 2-7 днів, ROI дуже низький, ймовірність штрафу 100% (але швидко).

LLM-generated PBNs: мережі з AI-контентом та складним маскуванням. TTL 1-3 місяці, ROI середній, ризик 80-90%. Стратегія “швидкого спалювання” з високою ймовірністю ручних санкцій.

Indexing API scaling: спроби масового додавання сторінок через API (фактично закрито). TTL практично нулевий після вересня 2024, ефективність нульова.

Cloaking (AI-powered): підміна контенту для ботів і користувачів. TTL 1-3 місяці, ROI середній, ризик 80-90%.

Scaling контенту: масова генерація без унікальної цінності. TTL 1-3 тижні, ROI низький, ймовірність штрафу 95-100%.

Померло або неефективно (повна втрата бюджету)

Статичні дорвеї: примітивні сторінки з повторюваним контентом. Виявляються системою за години через NLP-аналіз структури. Останній рік смерті: 2025 (August update).

Масова LLM-генерація: тисячі ідентичних сторінок без редагування. Причина смерті: NLP та SpamBrain detection. Неефективно з 2025 року.

Класичні PBN (1000+ сайтів): великі мережі з очевидними слідами. Виявляються за місяці, останні живі приклади зникли у 2023-2024 роках.

Keyword stuffing: перенасичення ключовими словами. Мертве з часів Panda + NLP, початок смерті 2011 рік.

Content spinning: автоматичне перефразування. Причина: статистичне виявлення, неефективно з 2013 року.

Link buying (очевидний): купівля посилань у футерах та сайдбарах. Виявляється через anchor text analysis і velocity. Мертве з 2012 року.

301 редирект без релевантності: перенаправлення з дропа іншої тематики. Google обнуляє вагу при виявленні зміни контексту.

Клоакінг за IP: примітивна підміна контенту. Миттєва фільтрація сучасними системами.

Google санкції та час відновлення

Manual проти Algorithmic покарань

Manual Penalty

передбачає явне повідомлення в Google Search Console, час відновлення 10-30 днів після подання reconsideration request. Частота: понад 400 тисяч на місяць. Реагування оперативне після виявлення.

Algorithmic Penalty

не має повідомлення (детектується через падіння трафіку), час відновлення 3-6 місяців (потрібно чекати наступного core update). Частота: мільйони сайтів, більшість випадків. Реагування поступове через масові санкції.

SpamBrain Real-Time Penalties (нове у 2025)

Інновація 2025 року полягає в тому, що Google почав видавати алгоритмічно-тригеровані покарання у реальному часі, а не чекати на core updates:

24 години: дорвей-сайт без унікального контенту отримує деіндекс.

72 години: PBN, виявлена як мережа, отримує м’який штраф (гасіння рангів).

Один тиждень: scaled content abuse призводить до видалення з SERP (повна деранкізація).

Причина швидкості: машинне навчання моделей SpamBrain може видавати рішення без очікування планових оновлень. Це радикально скоротило Time to Live більшості чорних методів.

Глен Гейб, відомий SEO-аудитор, попереджає: “Наш контент, створений штучним інтелектом, добре ранжується – так, саме це і є причиною, чому Google накладе на ваш сайт ручні санкції за Scaled Content Abuse.”

Гібридна стратегія безпеки: як мінімізувати ризики

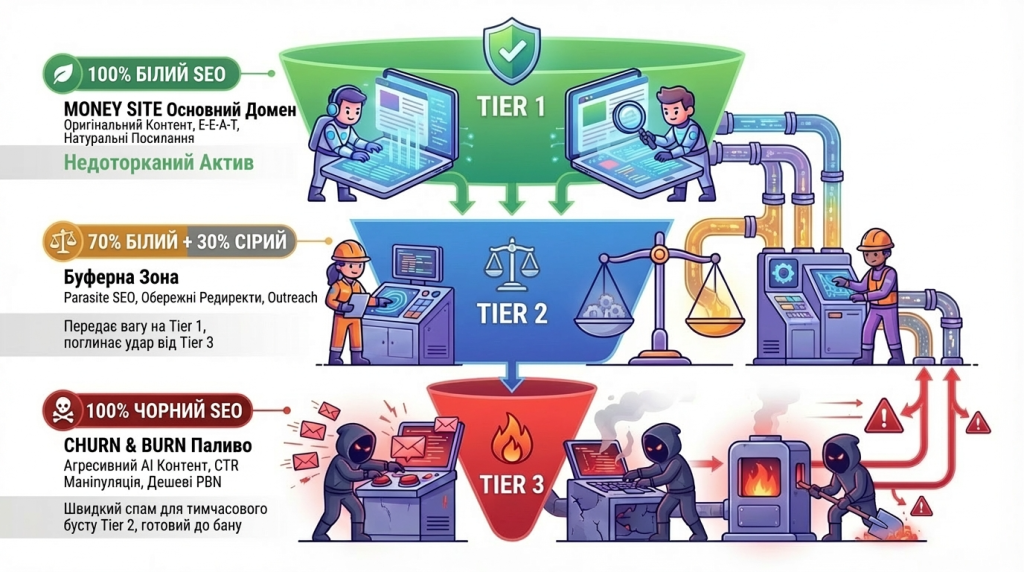

Якщо все одно використовуються ризиковані техніки, експерти рекомендують багаторівневий підхід:

Tier 1 проект (основний домен): 100% White Hat з оригінальним контентом, натуральними посиланнями, дотриманням E-E-A-T. Цей рівень має бути недоторканим.

Tier 2 проекти (паралельні, допоміжні домени): 70% White Hat + 30% Grey Hat із Parasite SEO, легкими expired domain redirects. Ці проекти підтримують основний, але не наражають його на прямий ризик.

Tier 3 проекти (“спалювані” домени): 100% Black Hat у форматі Churn & Burn. Усі ризиковані техніки застосовуються тут перед капітальною санкцією.

Стратегія безпеки: якщо Tier 3 згорає, Tier 1 залишається неушкодженим. Це дозволяє експериментувати з агресивними методами без загрози головному активу.

Технічні рекомендації

Для PBN використовуйте VPS із різних фізичних центрів даних, а не одного провайдера. Для Parasite SEO один домен повинен містити максимум 1-2 посилання на постійну цільову сторінку. Для AI-контенту мінімум 60% AI-generated + 40% human editing. Для посилань варіюйте anchor text (уникайте точних матчів), міксуйте з brand mentions.

"ШІ-контент — це цілком нормально, якщо він проходить курування людиною для забезпечення точності та оригінальності".

Гері Ілліш

Три фактори смерті Black Hat SEO у 2025 році

SpamBrain Evolution

машинне навчання, яке вчиться у реальному часі, замість очікування core updates. Система аналізує мільярди сторінок одночасно та виявляє патерни миттєво.

Real-Time Penalties

санкції видаються за дні, а не місяці. Час між порушенням та покаранням скоротився з місяців до годин або днів.

Cost-Benefit Collapse

шість місяців роботи над PBN може коштувати $2-5 тисяч за результат, що буде спалено за два тижні. Економічна доцільність чорних методів різко впала.

Black Hat SEO 2025 року – це гра на краю ножа зі швидкими наслідками. Те, що раніше давало 12 місяців ранжування, тепер дає 2-8 місяців. Доки Time to Live скорочується, затрати та складність зростають експоненціально.

Для довгострокового ранжування (понад два роки) White Hat із елементами обережного Grey Hat є єдиною життєспроможною стратегією. Для одноразових заробітків (affiliate campaigns) Tier 3 Churn & Burn розраховує на кількість проектів замість якості однієї мережі.

Гері Ілліш із Google підсумовує філософію компанії: “AI-контент – це цілком нормально, якщо він проходить курування людиною для забезпечення точності та оригінальності.”

Розуміння цих механізмів критично важливе для фахівців із кібербезпеки та білих SEO-інженерів, оскільки багато методів, які сьогодні вважаються чорними, згодом трансформуються у легітимні інструменти автоматизації. Проте у 2025 році Google виграв битву за масштаб, але все ще програє битву за контекст, що залишає вузькі вікна можливостей для найсприйнятливіших оптимізаторів.

Часті питання:

Чи працюють LLM-генеровані дорвеї у 2025 році?

Ні, практично мертві. Google використовує NLP для виявлення повторюваних лінгвістичних патернів у AI-контенті. Після August 2025 Spam Update сайти з масовою генерацією деіндексуються за дні. Домени отримують мітку від SpamBrain, і навіть нові якісні статті перестають ранжуватися.

Які платформи для Parasite SEO ще працюють?

Reddit працює добре (низький ризик), Medium працює з падінням на 50-60% (помірний ризик), LinkedIn під жорстким контролем (помірний ризик). Quora фактично не працює (високий ризик). Forbes Guest Posts потужні при справжній редакційній перевірці (низький ризик).

Що таке схема "Пироги" в арбітражі?

Багатошарова структура: Tier 1 (білі трастові сайти збирають органіку), середній шар (клоакінг відсікає ботів Google), нижній шар (цільова сторінка з офером). Склеювання через 301-редиректи та маніпуляції Canonical. Ефективність висока в арбітражі, ризик середній.

Яка стратегія найбезпечніша для довгострокового ранжування?

Багаторівнева: Tier 1 (100% White Hat, основний домен), Tier 2 (70% White + 30% Grey Hat, підтримуючі домени), Tier 3 (100% Black Hat Churn & Burn, спалювані проекти). Якщо Tier 3 згорає, Tier 1 залишається неушкодженим.